Temps de lecture : 3 pages (équivalent)

mots-clés : IA, test, intelligence générale, intelligence artificielle générative, Searle

En bref : aujourd’hui, la plupart des questions sur l’IA tournent autour du besoin de savoir si une IA, telle que nous les connaissons aujourd’hui, est capable de penser ou pas. Le test de la chambre chinoise permet de prendre du recul sur cette question et surtout de l’expliquer.

Chers lecteurs,

Quels ne sont les articles qui, chaque semaine, inventent une nouvelle performance des IA génératives…. Souvent avec des termes galvaudés. De fait, voici quelques semaines (début septembre) Apple faisait sa grand-messe annuelle de présentation de ses nouveaux téléphones, montres, etc. Quelle ne fut pas ma stupéfaction lorsqu’un journaliste d’une grande chaine nationale belge précise en ces mots : « Apple propose non seulement son Apple Intelligence, mais en plus elle est générative » … cela laisse songeur.

Consciente ou pas consciente ?

Telle est la question ! En effet, aujourd’hui, la « question qui fait peur » c’est bien sûr de savoir sur l’IA pourrait devenir plus intelligente que nous. Et même si les spécialistes dans ce domaine mesurent encore aujourd’hui la marge importante avant que cette éventualité puisse émerger des laboratoires d’Open IA ou de Google, pour ne citer qu’eux, il reste difficile d’exprimer simplement ce questionnement qui, au vu des réponses que les IA génératives nous fournissent, sont en capacité de nous faire douter.

Pourtant, le temps reste long avant de découvrir une machine qui comprend les réponses qu’elle donne, tel un être humain qui comprend et donc peut nuancer ses réponses en fonction de l’intentionnalité : si votre interlocuteur est fourbe, il peut vous donner une réponse sympathique tout en sachant que c’est pour vous faire trébucher juste après. Une machine ne peut pas être fourbe, car même si on lui programme la fourberie, elle n’arrivera pas à jouer sur des nuances telles que vous seriez en doute face à ses réponses.

De Turing à Searle…

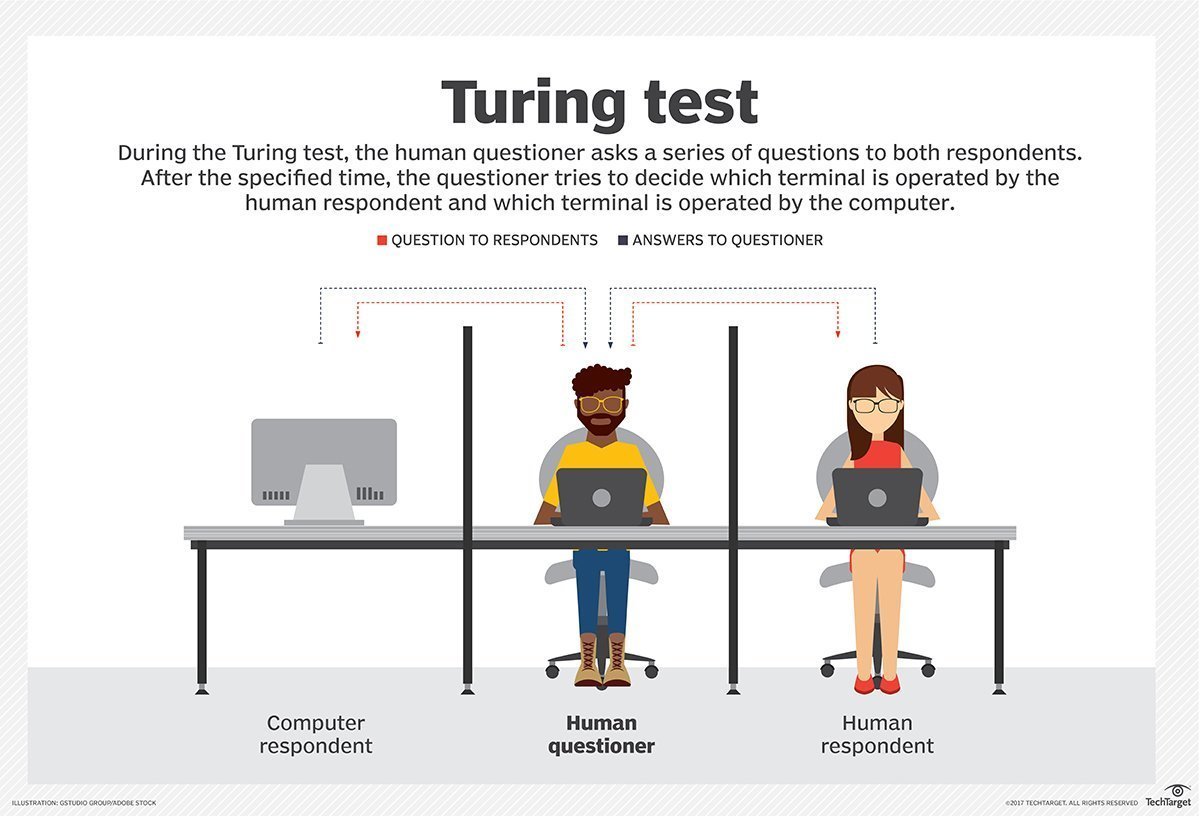

Vous avez certainement déjà entendu parler du test de Turing, inventé pour mesurer le niveau d’intelligence d’une machine. Le test de Turing est une méthode conçue pour évaluer la capacité d’une machine à imiter l’intelligence humaine. Imaginons une conversation textuelle entre un humain et une machine, sans que l’humain sache avec qui il interagit. Si l’humain est incapable de distinguer la machine de l’humain, alors la machine a « réussi » le test. Ce test, proposé par Alan Turing dans les années 1950, est un jalon important dans le domaine de l’intelligence artificielle et continue d’alimenter les débats sur la nature de l’intelligence.

Le test de Turing, bien qu’étant une pierre angulaire dans l’histoire de l’intelligence artificielle, présente plusieurs limites :

- La compréhension profonde : Le test se concentre principalement sur la capacité d’une machine à imiter la conversation humaine, mais il ne mesure pas la compréhension profonde des concepts, le raisonnement complexe ou la conscience de soi. Une machine pourrait réussir le test en manipulant des mots et des phrases sans véritablement comprendre leur signification.

- La créativité et l’originalité : Le test ne valorise pas la créativité, l’originalité ou la capacité à produire des idées nouvelles. Une machine pourrait exceller dans la simulation d’une conversation tout en étant incapable de créer de l’art, de la musique ou de la poésie.

- La nature subjective du test : Le succès d’une machine au test de Turing dépend en grande partie de l’interrogateur. Les critères de jugement peuvent varier d’une personne à l’autre, ce qui rend difficile d’établir un standard objectif.

- L’évolution des technologies : Avec l’évolution rapide des technologies, les capacités des machines augmentent constamment. Il est possible qu’une machine réussisse le test de Turing simplement en stockant et en manipulant une quantité massive de données, sans pour autant développer une véritable intelligence.

- Le caractère limité de la conversation textuelle : Le test de Turing se limite à une interaction textuelle. Il ne prend pas en compte d’autres aspects de l’intelligence humaine tels que la perception sensorielle, les émotions, le corps et les interactions sociales.

En résumé, le test de Turing est un outil utile pour évaluer certaines capacités des machines, mais il ne constitue pas une mesure complète de l’intelligence. Il est important de le considérer comme un point de départ et de développer d’autres méthodes pour évaluer de manière plus approfondie les progrès de l’intelligence artificielle.

Nous en arrivons donc au test de Searle. Nous commencerons par cet extrait de ses propos qui situent bien sa position : « Je ne connaissais rien [en 1971] à l’intelligence artificielle. J’ai acheté un manuel au hasard, dont la démarche argumentative m’a sidéré par sa faiblesse. Je ne savais pas alors que ce livre allait marquer un tournant dans ma vie. Il expliquait comment un ordinateur pouvait comprendre le langage. L’argument était qu’on pouvait raconter une histoire à un ordinateur et qu’il était capable ensuite de répondre à des questions relatives à cette histoire bien que les réponses ne soient pas expressément données dans le récit. L’histoire était la suivante : un homme va au restaurant, commande un hamburger, on lui sert un hamburger carbonisé, l’homme s’en va sans payer. On demande à l’ordinateur : “A-t-il mangé le hamburger ?”. Il répond par la négative. Les auteurs étaient très contents de ce résultat, qui était censé prouver que l’ordinateur possédait les mêmes capacités de compréhension que nous. C’est à ce moment-là que j’ai conçu l’argument de la chambre chinoise. »[1]. John Searle est professeur en langage, diplômé d’Oxford. Au début des années 1980, il suggère une expérience qui nous permet aujourd’hui de mieux nuancer la notion d’intelligence pour une machine qui, aujourd’hui, n’est capable que de « recopier » des notions dans des contextes spécifiques. Explications :

Imaginez une personne ne parlant pas chinois enfermée dans une pièce. On lui fournit un manuel de règles très détaillé expliquant comment associer des symboles chinois (des entrées) à d’autres symboles chinois (des sorties). Si une personne extérieure lui pose une question en chinois, la personne à l’intérieur peut, en suivant scrupuleusement le manuel, produire des réponses en chinois qui sembleront cohérentes. Searle soutient que, même si cette personne peut manipuler des symboles et produire des réponses qui pourraient tromper un interlocuteur, elle ne comprend pas réellement le chinois. Elle ne fait qu’appliquer des règles mécaniques. L’objectif de cette expérience est de montrer que :

- La manipulation de symboles ne suffit pas à la compréhension. Une machine, même si elle est capable de simuler une conversation intelligente, ne comprend pas nécessairement la signification des mots qu’elle utilise.

- La conscience et l’intelligence ne se réduisent pas à des processus de calcul. Il y a une dimension qualitative à la compréhension humaine que les machines ne peuvent pas reproduire simplement en suivant des règles.

En somme, l’expérience de la chambre chinoise est un argument contre l’idée que l’intelligence peut émerger uniquement de la manipulation de symboles, et qu’il existe une différence fondamentale entre la simulation de l’intelligence et l’intelligence véritable…. Dont l’une des expressions est la fourberie humaine.

Ses détracteurs ont vite attaqué les limites de l’expérience, tout comme celle de Turing posant la question de la simplification excessive de l’intelligence à la compréhension des signes, l’expérience, la nature de la compréhension. Par ailleurs, certains philosophes ont souligné que la personne dans la chambre pourrait développer une forme de compréhension en manipulant les symboles pendant une longue période. D’autres ont argumenté que la question de savoir si une machine peut « vraiment » comprendre est moins importante que sa capacité à se comporter de manière intelligente. Mais tout le monde reconnait aussi que l’expérience de la chambre chinoise est un outil utile pour réfléchir sur la nature de l’intelligence et les limites de l’intelligence artificielle, mais elle ne fournit pas de réponse définitive. Elle reste un sujet de débat important dans la philosophie et les sciences cognitives.

Analyse

Ce qui nous importe ici est de nuancer les éléments de langage pour qualifier l’IAG (G pour générative). Aujourd’hui, aucun logiciel d’IAG n’est vraiment intelligent. En caricaturant un peu, c’est un bon cuisinier avec cette phénoménale capacité à avoir lu la plupart de tous les livres de cuisine sur Terre. Dans ce contexte, il sera donc capable de vous proposer la meilleure recette pour un plat donné, aussi imaginatif soit-il, mais il n’arrivera pas à proposer un nouveau plat malgré sa connaissance acquise. Et c’est peut-être cela le plus important : la créativité pure de l’IA est proche de 0.

N’oublions pas que J. Searle est, avant d’être philosophe, un linguiste. La Chambre chinoise s’appuie initialement sur la multiplicité de sens que pourrait avoir une seule phrase, y compris, celle qu’elle prendrait dans un dialogue et ne correspond pas aux significations passées. C’est la nuance entre l’intelligence et l’intentionnalité. Alexandre Frédéric (INRIA Bordeaux) nous le précise en rappelant qu’un des problèmes majeurs que l’IA n’a toujours pas résolus aujourd’hui est celui de l’ancrage du symbole (symbol grounding problem), c’est-à-dire comment des symboles (des mots par exemple) peuvent être associés à leur signification. Par exemple, si je dis : « le chat dort sur son coussin, car il est fatigué », la plupart des êtres humains comprendra sans effort que « il » renvoie à « chat » et pas à « coussin ». C’est ce qu’on appelle le raisonnement de bon sens. Par contre, ce raisonnement va être beaucoup plus difficile en IA (source : ici, 2023).

Bonne et belle journée à vous.

Note : article partiellement rédigé avec Gemini (IAG de Google).

pour aller un peu plus loin (vulgarisation) :

https://youtu.be/_XJsAQsT0Bo?si=tj8kMfJf7Q9N-UVx

Merci pour le suivi de notre blog-à-idées ou à réflexions, c’est toujours agréable d’être lu et vous êtes de plus en plus nombreux (+ de 1 000 par mois en, moyenne). N’hésitez pas à commenter, c’est aussi une place de débats. Et surtout, merci de partager si vous soutenez nos réflexions ou recherches.

Pascal SIMOENS Ph.D, Architecte et urbaniste, data Scientist. Expert Smart Cities. J’ai commencé ma vie en construisant des villes en Lego, j’en ai fait mon métier. Geek invétéré, aujourd’hui je joins mes passions du numérique et de la ville au travers d’une expertise smart Cities et smart-buildings en travaillant en bureau d’étude (Poly-Tech Engineering) et j’enseigne cette même expertise à l’UMONS et l’ULB.

This post is licensed under a Creative Commons Attribution-NonCommercial 4.0 International License.

[1] « Langage, conscience, rationalité : une philosophie naturelle. Entretien avec John R. Searle », Le Débat, Paris, éditions Gallimard, no 109, mars-avril 2000, p. 177-192 (ISBN 2-07-075859-1, ISSN 0246-2346, e-ISSN 2111-4587, OCLC 7293544677, DOI 10.3917/deba.109.0177

« Dans ce contexte, il sera donc capable de vous proposer la meilleure recette pour un plat donné, aussi imaginatif soit-il, mais il n’arrivera pas à proposer un nouveau plat malgré sa connaissance acquise. Et c’est peut-être cela le plus important : la créativité pure de l’IA est proche de 0. » Je trouve que c’est déjà un grand avancement. J’aimerais bien avoir le diagnostic de 1000 médecins « IA » versus le diagnostic d’un seul médecin humain avant de me faire opérer. Très bon article. Bravo.

J’aimeJ’aime

Merci. Pour les IA de médecine, le travail amont du diagnostic est assez efficace… mais à la fin il faut un médecin en chair et en os.

J’aimeAimé par 1 personne