Temps de lecture : 9 minutes

mots-clés : Lunettes connectées, Post-smartphone, Vie privée, Capture vidéo, AGENT IA

Nombre de pages « équivalent » : 6

Article rédigé avec l’aide de l’IA : oui

En bref : Il y a des technologies qui arrivent trop tôt. Et d’autres qui reviennent au moment exact où la société a déjà changé, sans s’en rendre compte. Les lunettes connectées appartiennent à cette seconde catégorie : elles ne reviennent pas seulement “plus légères” ou “plus performantes”. Elles reviennent dans un monde qui a appris à vivre avec une caméra à la main — et à trouver cela banal.

Chers lecteurs, chères lectrices,

Chers abonné.e.s,

Introduction

Dans la rue, sur un quai, à la sortie d’un concert, à la terrasse d’un café, la scène est devenue ordinaire : quelqu’un filme. On ne sait pas toujours ce qu’il filme. Ni ce qu’il fera de la séquence. Et pourtant, la plupart du temps, personne ne dit rien. Ce n’est pas une approbation enthousiaste : c’est une indifférence apprise, un nouveau seuil de tolérance, un petit ajustement collectif de la notion d’intimité. C’est précisément dans cette fenêtre culturelle que les lunettes “caméra + IA + (bientôt) micro-écran” redeviennent crédibles. Pas comme gadget. Comme interface. Pour comprendre ce basculement, il faut passer par trois objets-totems :

- Google Glass : l’avant-garde… et le crash social.

- Humane AI Pin : le “post-smartphone” comme storytelling.

- La vague actuelle (Meta/Ray-Ban, et Alphabet via Android XR) : l’industrialisation d’un nouveau standard.

Google Glass : l’avant-garde… et le crash social

Google Glass, c’était une promesse simple : déporter l’écran vers le regard. Un HUD minimal, une caméra, quelques commandes vocales. Le smartphone, mais “dans” l’attention. Le calendrier en disait déjà beaucoup sur la réalité industrielle du projet : démo “Project Glass” en 2012, premiers exemplaires distribués aux “Explorers” en 2013, ouverture plus large en 2014, arrêt de la version grand public en 2015. Sur le papier, c’est rapide. Dans les faits, c’était juste un test social du marché.

On a souvent raconté cette histoire en termes techniques : batterie, chauffe, confort, UX. Mais ce que Glass a surtout testé, presque malgré lui, c’est la réaction de l’espace public à un nouvel acteur : la caméra portée sur le visage. Avec un smartphone, la gestuelle est lisible : tu lèves le bras, tu cadres, tu “montres” que tu filmes. Glass, lui, introduisait un doute : filme-t-il? Maintenant? moi? Le problème n’était pas seulement l’enregistrement ; c’était la discrétion de l’enregistrement, donc l’impossibilité de négocier le moment.

Le backlash a été culturellement violent : moqueries, interdictions dans certains lieux, émergence d’un vocabulaire délétère, tribunes, chroniques, débats sur la vie privée. L’objet est devenu un symbole — pas de réalité augmentée, mais de capture.

Google a ensuite repositionné l’objet vers l’entreprise (Glass Enterprise), avant de stopper la vente et le support. La conclusion facile a été : “Les lunettes connectées, c’est fini”. La conclusion utile est plutôt : la société n’était pas prête… et la tech non plus car dans les faits, personne n’avait envie de se balader avec des lunettes et un fil à la patte d’une batterie lourde et peu efficace.

Humane AI Pin : le “post-smartphone” comme storytelling

Saut dans le temps. Un autre objet arrive, non pas sur le visage, mais sur le torse : Humane AI Pin. Le pitch était presque parfait : un petit boîtier, une IA, de la voix, un micro-projecteur, et surtout une ambition : se passer du smartphone. Autrement dit : dématérialiser l’interface, et faire du téléphone un organe obsolète. Nous vous en avions parlé dans plusieurs articles de notre blog :

- Ai Pin : Probably the next step of the smarphone, 13 novembre 2023

- Chat GPT 4o + AI PIN = ANTHOTHER THINK LIKE HER, 22 mai 2024

- LA MORT DU SMARTPHONE EST ANNONCEE PAR OPEN AI ET APPLE , 22 juin 2025

Humane a réussi quelque chose de rare : faire parler du futur avant même que le produit ne prouve quoi que ce soit. C’était une victoire de branding : design épuré, rhétorique de libération, promesse d’un monde “moins écran”. Le prix a fait partie du récit : 699$, et surtout un abonnement récurrent. Une technique qui nous renvoi au futur : l’économie de rente chère à Y. Vafourakis dans son livre « les nouveaux serfs de l’économie ». Puis la réalité « produit » a frappé. Les critiques ont été sévères : performances, limites d’usage, friction, promesse trop haute. Et la trajectoire s’est terminée brutalement : acquisition d’actifs par HP, arrêt du produit, et extinction des fonctions connectées à une date fixe (un détail presque cruel, car il dit tout de notre dépendance aux services).

On pourrait raconter l’AI Pin comme un échec. Mais ce serait passer à côté de sa fonction historique : rendre désirable l’idée d’un “après smartphone”. Humane n’a peut-être pas livré un bon produit. Mais l’entreprise a prouvé qu’il existait un public — et un imaginaire collectif — prêts à croire à une interface qui disparaît.

Cela a préparé les consommateurs vers le terrain des possibles pour les lunettes : elles ont un avantage décisif sur un boîtier pectoral. Elles se posent là où l’interface a toujours rêvé d’être : dans l’axe du regard. Le reste sera dans la poche.

La vague actuelle : Meta/Ray-Ban et le retour d’Alphabet via Android XR… sans oublier le Space computer d’Apple.

Aujourd’hui, le mouvement n’a plus le parfum d’un prototype. Il a une stratégie industrielle.

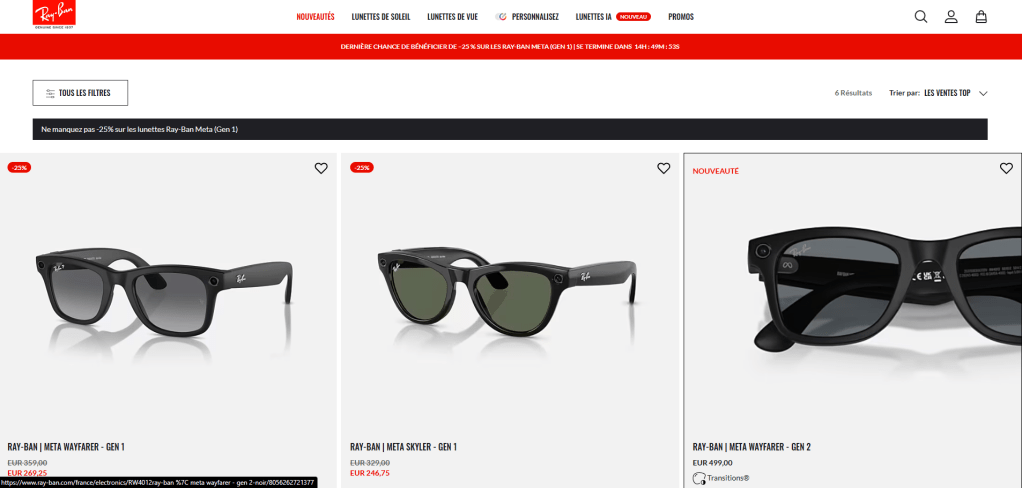

- Meta + Ray-Ban : banaliser l’IA portable

La collaboration Meta x EssilorLuxottica a une intelligence simple : faire passer la tech par un objet socialement accepté. Ray-Ban, c’est l’anti-gadget. C’est la normalité cool.

La génération annoncée en 2023 insiste sur une recette pragmatique : caméra, audio, capture facile, partage, et surtout la promesse d’une interaction “Hey Meta” qui rend l’IA portable, donc quotidienne. Le passage le plus intéressant arrive quand l’écran entre dans la danse. Depuis l’automne 2025, la presse et Meta évoquent une version Ray-Ban Display : l’idée bascule de “capturer et écouter” vers “superposer et agir”. À ce moment-là, on quitte le wearable accessoire pour entrer dans l’interface primaire.

Et un signal faible devient soudain un signal fort : Meta ralentit son expansion internationale faute de stock, en raison d’une demande élevée. Ce type de contrainte, d’habitude, ne concerne pas les gadgets. Il concerne les produits qui trouvent une fonction.

- Alphabet (Google) : Android XR, lunettes “all day”, partenaires mode

En parallèle, Google revient par une autre porte : Android XR, présenté comme un OS “IA-powered” (Gemini) pour casques et lunettes. Là encore, le détail révélateur n’est pas seulement technique : ce sont les partenaires. Gentle Monster, Warby Parker… et l’idée explicite de lunettes “que vous aurez envie de porter toute la journée”. Autrement dit : Google a intégré la leçon de Glass. Le problème n’était pas seulement la batterie ou le processeur ; il était aussi esthétique, social, vestimentaire. Les lunettes sont un objet identitaire — presque un visage secondaire. On ne “porte” pas des lunettes comme on “porte” un téléphone. On les habite.

The GAME CHANGING : nous avons déjà accepté la caméra

Revenons à la question la plus simple — donc la plus décisive :

Allez-vous interpeller quelqu’un qui filme dans la rue, dans votre direction, avec son smartphone ?

La plupart du temps : non.

Pourquoi ? Parce que le smartphone a imposé un nouvel état de fait : l’espace public est enregistrable. On peut trouver cela regrettable, pratique, ou inévitable — mais c’est devenu une norme de comportement. On a appris à vivre avec le fait d’être dans le champ de quelqu’un d’autre, sans contrôler l’usage final. Google Glass arrivait dans une époque où cette norme n’était pas intégrée dans notre « commun ». D’où la crispation : la caméra était perçue comme une transgression. Aujourd’hui, la caméra est partout : dashcams, caméras de vélos, caméras de magasins, caméras de téléphones. Ce qui choque moins, ce n’est pas le fait d’être filmé ; c’est l’intention (harcèlement, humiliation) et la publication.

Dans les mots de Steve Mann, pionnier du wearable, l’époque a glissé vers une zone grise entre surveillance et “sousveillance” : la possibilité, pour chacun, de capter le monde — et donc de contester, de prouver, mais aussi de traquer et d’exposer.

Toutefois, si l’obstacle psychologique diminue, ce qui devient central, c’est la chaîne complète:

capturer → comprendre → sélectionner → publier → recommander → monétiser

Et c’est là que l’IA fait basculer le système. Car les lunettes ne seront pas seulement des caméras. Elles seront des agents : elles verront, décriront, résumeront, traduiront, tagueront. Elles feront remonter des moments “importants”, généreront automatiquement des stories, des comptes-rendus, des “souvenirs”, des preuves. Bref, une utilité réelle dans un temps qui court toujours plus vite… à mon grand regret ! et précisions : le passage d’un monde “on filme parfois” à un monde “tout peut être loggé” ne dépend pas du capteur. Il dépend du service. C’est le point clé d’une diffusion de la technologie qui ruisselle par les usages. Pas parce que tout le monde deviendra voyeur, mais parce que les services proposeront des bénéfices immédiats :

- navigation piétonne

- traduction en temps réel

- aide contextuelle

- assistance mains libres

- mémoire externalisée

À partir de là, filmer n’est plus un acte volontaire. C’est un sous-produit de l’assistance.

Et c’est aussi là que la question politique se déplace : on ne débat plus “des lunettes”, on débat du modèle de données. Ce que Shoshana Zuboff a conceptualisé comme “surveillance capitalism” (article de Joanna Kavenna, , the Guardian, 4 octobre 2019) n’est pas l’existence de capteurs, mais l’industrialisation de l’expérience humaine comme matière première pour la prédiction et l’influence. Les lunettes peuvent devenir l’interface parfaite de cette économie : parce qu’elles capturent l’attention, le contexte, et parfois même l’émotion (par la voix, les micro-gestes, la situation).

Pour conclure : “On se revoit dans 5 ans ?”

Dans cinq ans, le smartphone ne disparaîtra pas. Il changera de rôle. Il deviendra un serveur personnel : batterie, connectivité, stockage, identité, paiements — mais moins interface. L’interface se déplacera vers :

- le visage (lunettes) pour l’info contextuelle

- l’oreille (audio) pour l’assistance discrète

- la voix (dialogue) pour l’action

- parfois le poignet (gestes) pour le contrôle avec la smart Watch

Le point d’inflexion arrivera quand l’écran des lunettes deviendra suffisamment bon pour deux choses :

- lire / répondre sans sortir le téléphone

- naviguer / agir sans friction

À ce moment-là, le smartphone devient un objet qu’on porte plutôt qu’on regarde.

Quoi, nous n’avons pas parlé d’intimité ? Ce fameux RGPD… c’est une vraie question éthique qui mériterait d’en débattre aujourd’hui pour qu’on ne soit pas encore et comme souvent en ce moment, à courir derrière les enjeux éthiques de l’IAG. Je ne pense pas qu’elle va disparaître, mais elle va devoir se reconfigurer. Ce qui manque encore — et qui déterminera l’acceptation sociale —, ce sont entre autres des protocoles visibles :

- Signaux clairs quand l’enregistrement a lieu (lumière, son, geste)

- Modes “privacy” imposés dans certains lieux

- Traitements locaux plutôt que cloud, quand c’est possible

- Règles de plateforme sur la publication automatique

Sans oublier quelques garde-fous législatifs à adapter. Sans cela, le conflit réapparaîtra, mais sous une forme différente. Au lieu de « tu m’as filmé », il sera plutôt « tu m’as indexé », « tu m’as reconnu » ou « tu m’as inclus dans un ensemble de données ».

On peut lire cette histoire comme une saga de produits inutiles : Glass, Pin, Ray-Ban, Android XR. Mais la lecture la plus juste est peut-être celle-ci : nous sommes en train de changer d’architecture d’interface. L’écran “dans la poche” a dominé parce qu’il était un compromis : puissant, privé, contrôlable. Les lunettes reviennent parce qu’elles proposent l’inverse : contextuel, immédiat, ambiant, et de plus en plus socialement invisible.

La technologie est presque prête : batterie, poids, recharge, intégration. Mais la condition la plus déterminante est déjà remplie : nous avons franchi le seuil culturel qui rend acceptable la caméra ordinaire. On s’en étonne soi-même…

Néanmoins, de nombreux problèmes restent en suspens. Et si on y réfléchissait maintenant ? Sinon, on se revoit dans cinq ans. Et d’ici là, regardez bien la rue : le futur n’arrive pas comme une annonce, il arrive comme une habitude.

Bonne et belle journée à vous.

Pour approfondir :

- Google Glass (chronologie / arrêt) : https://en.wikipedia.org/wiki/Google_Glass

- Fin de vente de Glass Enterprise Edition (officiel) : https://support.google.com/glass-enterprise/customer/answer/13417888?hl=en

- Arrêt Explorer Program (2015) : https://time.com/3669927/google-glass-explorer-program-ends/

- Humane AI Pin (prix / adoption) : https://www.theverge.com/2024/10/23/24277964/humane-slashes-ai-pin-price-weak-sales

- Humane : acquisition HP & shutdown :

- Ray-Ban Meta (officiel) : https://about.fb.com/news/2023/09/new-ray-ban-meta-smart-glasses/

- Ray-Ban Meta (page produit) : https://www.ray-ban.com/usa/ray-ban-meta-ai-glasses

- Meta Connect 2025 (Ray-Ban Display) : https://www.meta.com/blog/meta-ray-ban-display-ai-glasses-connect-2025/

- Reuters (demande/rollout 2026) : https://www.reuters.com/business/meta-delays-global-rollout-ray-ban-display-glasses-strong-us-demand-supply-2026-01-06/

- Android XR (Google, 2024) : https://blog.google/products-and-platforms/platforms/android/android-xr/

- Android Show XR Edition (Google, 2025) : https://blog.google/products-and-platforms/platforms/android/android-show-xr-edition-updates/

- Steve Mann (Sousveillance, PDF) : https://ojs.library.queensu.ca/index.php/surveillance-and-society/article/download/3344/3306/5654

- Zuboff (HBS) : https://www.hbs.edu/faculty/Pages/item.aspx?num=56791

Merci pour le suivi de notre blog-à-idées ou à réflexions, c’est toujours agréable d’être lu et vous êtes de plus en plus nombreux (+ de 1 000 par mois en, moyenne). N’hésitez pas à commenter, c’est aussi une place de débats. Et surtout, merci de partager/liker si vous soutenez nos réflexions ou recherches. C’est un véritable soutien de votre part et il est apprécié à sa juste valeur.

Dr. Pascal SIMOENS, Architecte et urbaniste, data Scientist.

J’ai commencé ma vie en construisant des villes en Lego, j’en ai fait mon métier. Geek invétéré, aujourd’hui je joins mes passions du numérique et de la ville au travers d’une expertise smart Cities et smart-buildings comme responsable » R&D au sein du groupe Pirnay (Charleroi-Bruxelles) et plus particulièrement de sa section S²Enginnering (smart & sustainable) . En même temps, j’enseigne cette expertise et continue la recherche dans les domaines de l’IA, l’architecture et la réduction de l’entropie du processus constructif au sien de l’UMONS. Je représente également les universités d’Etat de la communauté Française au sein du Conseil National de l’Ordre des architectes et du Conseil francophone et germanophone.

This post is licensed under a Creative Commons Attribution-NonCommercial 4.0 International License.