Temps de lecture : 6 minutes

Mots-clés : benchmarking, Open IA, Perplexity, CoPilot, Wallstreet Journal, Entropie, théorie de l’information, Information theory

Chers lecteurs,

Le domaine de recherche dans lequel je travaille m’amène à régulièrement travailler avec des IA. Dans ce contexte, les IA sémantiques et génératives sont mon quotidien et je ne doute pas que vous vous laissez de plus en plus aller à demander à un Chat ou autre de résumer une question complexe, à tout le moins, moins évidente qu’à l’habitude. Félicitation, vous vous êtes déjà adapté à un nouveau moyen d’améliorer votre travail ! Toutefois, vous êtes-vous déjà demandé si votre IA générative préférée est la meilleure ?

Le Wall street Journal l’a fait pour vous.

Avec son article The Great AI Challenge: We Test Five Top Bots on Useful, Everyday Skills (25 mai 2024), le Wall street Journal a relaté une compétion de type “jeux Olympiques » d’IAG à laquelle ils se sont prêtés. Le principe est simple : demander à plusieurs modèles d’IAG de fournir des réponses et ensuite les analyser à l’aulne de la vérité scientifique.

Dans ce jeu, les sommes ne sont pas nulles et contrairement à ce qu’on imagine, les réponses ne sont pas identiques, mais bien similaires. À nouveau, cette expérience démontre que non seulement les bases de données définissent les réponses, mais aussi tout autant les algorithmes qui décryptent ces données pour en proposer des réponses plus ou moins nuancées.

Dans ce benchmarking du WSJ, les 5 IA testées étaient :

En fonction de la qualité des réponses, le résultat global est sans appel :

- Perplexity AI

- OpenAI’s ChatGPT

- Google’s Gemini

- Anthropic’s Claude

- Microsoft’s Copilot

Et je ne suis pas étonné, j’utilise moi-même les 3 premières IA et dans l’ordre selon mes besoins de précisions et certitudes dites « critiques ». J’ai testé un temps Copilot pour définitivement l’abandonner.

Le test pour comprendre toutes les nuances : Entropie et information

Ce 30 mai 2024, je devais présenter quelques idées à un groupe scientifique et… j’ai rarement été aussi mauvais. Ça arrive, il y en aura d’autres. L’objet de cette présentation était, entre autres, mon approche de recherche du lien entre l’entropie énergétique et la théorie de l’information… qui traite également de l’entropie. L’objet de ce travail est de trouver des liens systémiques ou antagonistes qui sont encore non définis, entre l’entropie dans la construction et l’entropie des usages à travers l’information. Là, je me dis que je vous ai déjà perdu pour la plupart et soyez rassurés, je m’y perds encore aujourd’hui. Toutefois, et lisant cet article du WSJ, je ne suis amusé à poser la question à 3 IA facilement disponibles : Peut-on créer des liens entre les lois de l’entropie énergétique et la théorie de l’information de Claude Shannon ? Cette question est compliquée, nécessite de la nuance et c’est bien cela l’intérêt.

Réponse de Perplexity AI :

Oui, il est possible de créer des liens entre les lois de l’entropie énergétique et la théorie de l’information de Claude Shannon.

Liens entre l’entropie énergétique et la théorie de l’information :

- Identité de l’expression mathématique:

L’expression mathématique de l’entropie de Shannon est identique à celle de l’entropie de Gibbs, qui mesure l’incertitude statistique dans un système thermodynamique.

Cette identité montre que l’entropie de Shannon, qui mesure la quantité d’information, est liée à l’entropie énergétique, qui mesure l’incertitude statistique dans un système thermodynamique.

- Néguentropie :

Léon Brillouin a introduit le concept de néguentropie, qui représente l’information transmise par les gènes dans les systèmes vivants. Cette notion montre que les systèmes vivants peuvent diminuer leur entropie interne grâce au flux d’énergie qui les traverse.

- Coût de l’effacement d’information :

Landauer a montré que l’effacement d’information nécessite un coût en entropie et en énergie. Cela signifie que la suppression d’information implique une augmentation de l’entropie et une consommation d’énergie.

- Rôle de l’information dans la lutte contre l’entropie :

L’information est considérée comme un moyen de lutter contre l’entropie et l’incertitude. Elle permet de réduire l’incertitude en fournissant des détails supplémentaires sur un système, ce qui réduit ainsi l’entropie.

- Applications dans la compression de données :

L’entropie de Shannon est utilisée pour quantifier le nombre minimum de bits nécessaires pour coder un fichier, ce qui permet de compresser les données sans perte. Cela montre que l’information peut être utilisée pour réduire l’entropie et ainsi diminuer la quantité d’énergie nécessaire pour stocker ou transmettre des données.

En résumé, les liens entre l’entropie énergétique et la théorie de l’information de Claude Shannon sont multiples et montrent que l’information peut être utilisée pour réduire l’entropie et l’incertitude dans les systèmes, tant vivants que non vivants.

Réponse d’Open AI-ChatGPT4o :

Oui, il existe des liens conceptuels entre les lois de l’entropie énergétique et la théorie de l’information de Claude Shannon. Ces liens se manifestent principalement à travers le concept d’entropie, qui joue un rôle central dans les deux domaines. Voici une explication détaillée de ces connexions :

1. Entropie en Thermodynamique

En thermodynamique, l’entropie est une mesure de l’ordre, du désordre ou de l’incertitude dans un système physique. Elle est souvent associée à la deuxième loi de la thermodynamique, qui stipule que l’entropie totale d’un système isolé ne peut qu’augmenter au fil du temps, reflétant la tendance naturelle des systèmes à évoluer vers un état de désordre maximal.

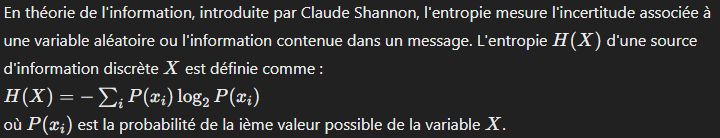

2. Entropie en Théorie de l’Information

En théorie de l’information, introduite par Claude Shannon, l’entropie mesure l’incertitude associée à une variable aléatoire ou l’information contenue dans un message.

3. Liens conceptuels entre les Deux Types d’Entropie

3.1. Mesure de l’Incertitude

Dans les deux contextes, l’entropie est une mesure de l’incertitude ou du désordre. En thermodynamique, elle quantifie le désordre d’un système physique, tandis qu’en théorie de l’information, elle quantifie l’incertitude sur l’état d’une source d’information.

3.2. Analogies mathématiques

Les formules mathématiques de l’entropie en thermodynamique et en théorie de l’information présentent des similitudes. Par exemple, la formule de Boltzmann pour l’entropie en thermodynamique

3.3. Applications dans les Systèmes physiques et d’Information

Physique statistique : La théorie de l’information de Shannon est souvent utilisée dans la physique statistique pour analyser les systèmes thermodynamiques. Par exemple, l’entropie de Shannon peut décrire la distribution des particules dans un système gazéifié.

Compression de Données : La compression de données en théorie de l’information utilise le concept d’entropie pour minimiser la redondance, similaire à la manière dont la thermodynamique cherche à comprendre les configurations micro-états les plus probables d’un système.

4. Interprétations et Implications

Interprétation physique de l’Information : Léon Brillouin et d’autres ont montré que l’acquisition d’information sur un système physique réduit son entropie, une idée encapsulée dans le concept de « négentropie » (entropie négative). Cela implique que l’information peut être vue comme une forme de réduction de l’incertitude ou du désordre.

Entropie et Complexité : Les systèmes complexes, tant en physique qu’en théorie de l’information, sont souvent caractérisés par des niveaux élevés d’entropie. Cependant, l’organisation et l’émergence de structures (en dépit de l’augmentation de l’entropie) sont des phénomènes étudiés dans les deux domaines.

Conclusion

Les lois de l’entropie en thermodynamique et la théorie de l’information de Claude Shannon sont conceptuellement liées par leur utilisation de l’entropie comme mesure de l’incertitude et du désordre. Bien que les contextes soient différents, les analogies mathématiques et conceptuelles permettent des applications croisées et une meilleure compréhension des systèmes complexes, qu’ils soient physiques ou informationnels. Ces liens enrichissent notre compréhension de l’information et de l’énergie, fournissant des perspectives utiles dans divers domaines scientifiques et technologiques.

Réponse de Gemini :

Oui, il existe des liens profonds entre les lois de l’entropie énergétique et la théorie de l’information de Claude Shannon.

1. Une mesure commune : l’entropie

Entropie thermodynamique: introduite par Rudolf Clausius en 1865, elle quantifie le désordre et la dispersion d’énergie dans un système physique. Plus l’entropie est élevée, plus le système est désorganisé.

Entropie de l’information: définie par Claude Shannon en 1948, elle mesure l’incertitude et la quantité d’information contenue dans un message. Plus l’entropie est élevée, plus le message est incertain et riche en information.

2. Le lien fondamental : la relation entre information et énergie

Codage et bruit : D’après le théorème de codage de Shannon, il existe une limite fondamentale à la quantité d’information qu’il est possible de transmettre sur un canal de communication bruyant. Cette limite est directement liée à l’entropie du canal.

Thermodynamique de l’information : Cette branche relie l’information à la thermodynamique en considérant l’énergie nécessaire pour stocker, traiter et transmettre des informations.

3. Applications et exemples

Compression de données : Les algorithmes de compression, comme JPEG pour les images, exploitent le lien entre entropie et information pour réduire la quantité de données nécessaires à la représentation d’un message, tout en préservant l’information essentielle.

Limites de l’intelligence artificielle : L’apprentissage automatique et l’intelligence artificielle sont limités par la thermodynamique de l’information. Le traitement de grandes quantités de données requiert de l’énergie, et il existe des limites physiques à la performance des algorithmes.

4. Au-delà de l’analogie : vers une théorie unifiée

Certains chercheurs explorent l’idée d’une théorie unifiée de l’information qui relierait l’entropie thermodynamique, l’entropie de l’information et d’autres concepts fondamentaux de la physique et de l’informatique.

Conclusion

Les liens entre l’entropie énergétique et la théorie de l’information de Shannon révèlent une profonde connexion entre l’information, l’ordre et l’énergie dans l’univers. Ces concepts apparemment disparates s’avèrent intimement liés, offrant de nouvelles perspectives pour la compréhension de la physique, de l’informatique et de la vie elle-même.

Réponse de Co-Pilot :

Bien sûr ! La théorie de l’information développée par Claude Shannon et Warren Weaver en 1948 propose une mesure quantitative du manque d’information, exprimée par l’entropie statistique. Intéressant, n’est-ce pas ?

Voici quelques points de connexion entre les deux domaines :

Entropie et désordre : L’entropie est un concept central en physique statistique. Elle mesure le désordre ou l’incertitude dans un système. Dans la théorie de l’information, Shannon a utilisé une formule similaire à celle de Boltzmann pour l’entropie. Cette formule relie la probabilité d’apparition d’un élément ou signal à l’entropie. En thermodynamique, l’entropie est liée à la perte d’énergie utilisable dans un système isolé.

Quantité d’information et entropie : Shannon a remarqué que l’expression mathématique de la quantité d’information ressemblait à celle de l’entropie.

La formule fondamentale de l’entropie de Shannon est la suivante :

est la probabilité d’apparition d’un élément ou signal quelconque.

Intervention extérieure et information : L’entropie est irréversible, mais elle peut être contredite par une intervention extérieure, notamment par l’information. Les organismes biologiques savent tirer parti de l’information pour réduire l’entropie et maintenir leur ordre.

En somme, l’entropie et la théorie de l’information sont étroitement liées, et elles nous aident à comprendre le monde physique et les systèmes de communication. Si vous avez d’autres questions, n’hésitez pas !

Analyse des 4 propositions

Tout d’abord, nous avons été étonnés par la nuance proposée par chaque IA, ce qui est loi d’être anodin dans un domaine de recherche où il n’y a aucune certitude de la manière dont la théorie de l’information peut être liée mathématiquement avec celle de l’entropie. Certes, on sait qu’il y a un lien, par contre, le trouver de manière la plus objective dans le contexte de la recherche actuelle est une tout autre histoire. Dans ce contexte, on s’étonne de la réponse de Copilot qui est la moins nuancée : bien sûr ! La théorie de l’information développée (…). À comparer aux autres nuances :

- Gemini : Oui, il existe des liens profonds entre les lois de l’entropie énergétique et la théorie de l’information de Claude Shannon.

- ChatGPT4o : Oui, il existe des liens conceptuels entre les lois de l’entropie énergétique et la théorie de l’information de Claude Shannon.

- Perplexity : oui, il est possible de créer des liens entre les lois de l’entropie énergétique et la théorie de l’information de Claude Shannon.

Cette simple phrase d’introduction de la réponse des différentes IA démontre à quel point une IA n’est pas l’autre. Nous ajouterons que Perplexity, ChatGPT et Gemini ont tous proposé, mais à des degrés divers, des articles scientifiques peux probants. CoPilot offre des ressources telles Universalis et The Conversation (revue en ligne de la vulgarisation scientifique), la plupart renvoient à Jean Zin, un militant altermondialiste et écologiste français, également philosophe marxien et qui propose une synthèse de la potentielle théorie du tout, reliant la vie, l’information et l’entropie. On lui reconnaitra une véritable érudition et curiosité qui mérite lecture pour ceux qui seraient plus intéressés à ce sujet, mais nous sommes loin d’une analyse scientifique (le monde de l’information, Jean Zin , 2004). Pour le reste l’ensemble des réponses viennent donc de sources similaires et le contenu s’en ressent. Nous sommes loin de la valeur scientifique, ce n’est pas pour autant que les réponses soient mauvaises. Elles sont justes généralistes. Toutefois, nous relevons que la plus avancée en termes d’analyse de la complexité de la question posée et donc des potentielles réponses qui permettraient de vouloir aller plus loin dans vos recherches et, sans aucun doute Perplexity.

Dans ce contexte, l’important est de mettre les formes pour que ces approches généralistes face à une question complexe soient les plus nuancées possibles, car la nuance nécessite à l’IA d’aller recherche un champ plus large de ses bases de données. Et la nuance est ce qui est fondamental dans une société démocratique. Bref, imaginons la réponse sur la vie et la mort, l’avortement, la Palestine aujourd’hui… sans nuances. Les premières amorces de l’idocratie nous guettent si nous ne prenons pas à bras le corps ces questions dans le cadre de l’éducation fondamentale à l’utilisation de l’IA. Ce n’est pas à l’université qu’on doit commencer à apprendre à utiliser ces outils de manière critique mais bien déjà en primaire et secondaire. les pédagogues et les philosophes feraient mieux de s’emparer de la question.

Bonne et belle journée à vous.

Merci pour le suivi de notre blog-à-idées ou à réflexions, c’est toujours agréable d’être lu et vous êtes de plus en plus nombreux (+ de 1 000 par mois en, moyenne). N’hésitez pas à commenter, c’est aussi une place de débats. Et surtout, merci de partager si vous soutenez nos réflexions ou recherches.

Pascal SIMOENS Architecte et urbaniste, data Scientist, PhD. Expert Smart Cities. J’ai commencé ma vie en construisant des villes en Lego, j’en ai fait mon métier. Geek invétéré, aujourd’hui je joins mes passions du numérique et de la ville au travers d’une expertise smart Cities et smart-buildings en travaillant en bureau d’étude (Poly-Tech Engineering) et j’enseigne cette même expertise à l’UMONS et l’ULB.

This post is licensed under a Creative Commons Attribution-NonCommercial 4.0 International License.